Naszą wizją jest umożliwienie każdemu realizacji swoich 3D wyobrażeń. Dlatego stworzyliśmy Meshy-1, szybkie generatywne AI dla 3D, które umożliwia twórcom treści przekształcanie tekstu i obrazów w fascynujące modele 3D w mniej niż minutę.

W tym blogu z radością odsłaniamy historię stojącą za Meshy-1 i jego możliwościami[]. Przygotuj się na zachwyt!

Dlaczego GenAI dla 3D jest ważne (i trudne)?

Wzrost interaktywnej treści 3D, szczególnie w branżach gier, filmów i XR, spowodował wzrost zapotrzebowania na modele 3D. Eksperci twórcy stają przed długimi czasami produkcji, podczas gdy amatorzy zmagają się z złożonymi narzędziami, takimi jak Maya czy Blender. Ta luka, potęgowana przez bariery kosztów i złożoności, wymaga rozwiązania.

Teraz jest kluczowy moment. Z wprowadzeniem Vision Pro od Apple i Quest 3 od Meta, w połączeniu z szybkim postępem technologii generatywnego AI i rozwijającym się rynkiem gier, zbiorowe oczekiwanie na przełomowe generatywne AI dla 3D jest wyczuwalne i gotowe do realizacji.

![]()

W tej ekscytującej erze generatywnego AI pojawia się wiele potężnych produktów w różnych modalnościach. Na przykład, widzimy ChatGPT dla tekstu, Midjourney dla obrazów i Runway dla wideo.

Chociaż może się wydawać logiczne, że generacja 3D jest kolejnym krokiem, intrygująco, nie ma jednoznacznego lidera w tej dziedzinie, głównie dlatego, że przepis na stworzenie produktu łatwego w użyciu pozostaje nieodkryty. Dlaczego tak jest?

Moja podróż przez akademię i przemysł [1] dostarcza wglądu w przyczyny tego stanu rzeczy.

Wyzwanie 1: Kompromis między jakością a szybkością. Obecnie istnieją dwa dominujące podejścia w dziedzinie 3D GenAI:

- 2D Lifting: Podnoszenie modeli generatywnych 2D (takich jak Stable Diffusion) do 3D, wykorzystując iteracyjne techniki optymalizacyjne stosowane do struktur takich jak NeRFs. Te metody wykorzystują dużo danych 2D i mogą tworzyć różnorodne modele 3D o dobrej jakości, ale są powolne i mogą zająć godziny nawet na szybkich GPU jak RTX 3080.

- 3D Diffusion: To podejście znacznie skraca czas generacji do mniej niż 1 minuty na model. Ponieważ nie ma zbyt wielu danych treningowych 3D, modele tworzone w ten sposób często nie mają dobrej jakości.

![]() Obecne metody są albo zbyt wolne, albo nie mają pożądanej jakości, co utrudnia rozwój skutecznego produktu. Meshy ma na celu być zarówno szybkie, jak i wysokiej jakości.

Obecne metody są albo zbyt wolne, albo nie mają pożądanej jakości, co utrudnia rozwój skutecznego produktu. Meshy ma na celu być zarówno szybkie, jak i wysokiej jakości.

Dlatego nie ma wielu produktów 3D GenAI na rynku. Użycie 3D diffusion skutkuje niską jakością, podczas gdy 2D lifting prowadzi do długiego czasu oczekiwania dla użytkowników i wysokich kosztów serwerowych. Nasz zespół ciężko pracował, aby połączyć zalety obu podejść i pokonać kompromis między jakością a szybkością, tworząc produkt, który pozwala użytkownikom przekształcać tekst/obrazy w dobre modele 3D w mniej niż minutę.

![]()

Wyzwanie 2: Przepaść między innowacjami akademickimi a potrzebami użytkowników. Produkt zorientowany na użytkownika wykracza poza same algorytmy i wagi sieci neuronowych; wymaga intuicyjnych interfejsów użytkownika i płynnej integracji z powszechnymi narzędziami, takimi jak Unity i Blender. Ponadto, musi oferować zarządzalne liczby wielokątów odpowiednie dla gier mobilnych i zapewniać skuteczną kontrolę treści/stylu, aby autentycznie materializować pomysły użytkowników. Chociaż produktowanie nie jest nauką rakietową, wymaga głębokich wglądów w produkt i głębokiego zrozumienia branży CG do opracowania. [2]

Meshy-1: 3D GenAI Szybki i Doskonały

Jak wcześniej wspomniano, jeśli proces generowania trwa godziny, staje się wyzwaniem stworzenie produktu, który może skalować się nawet do setek użytkowników. Dlatego jako twórca, pilne jest najpierw rozwiązanie problemu szybkości.

![]()

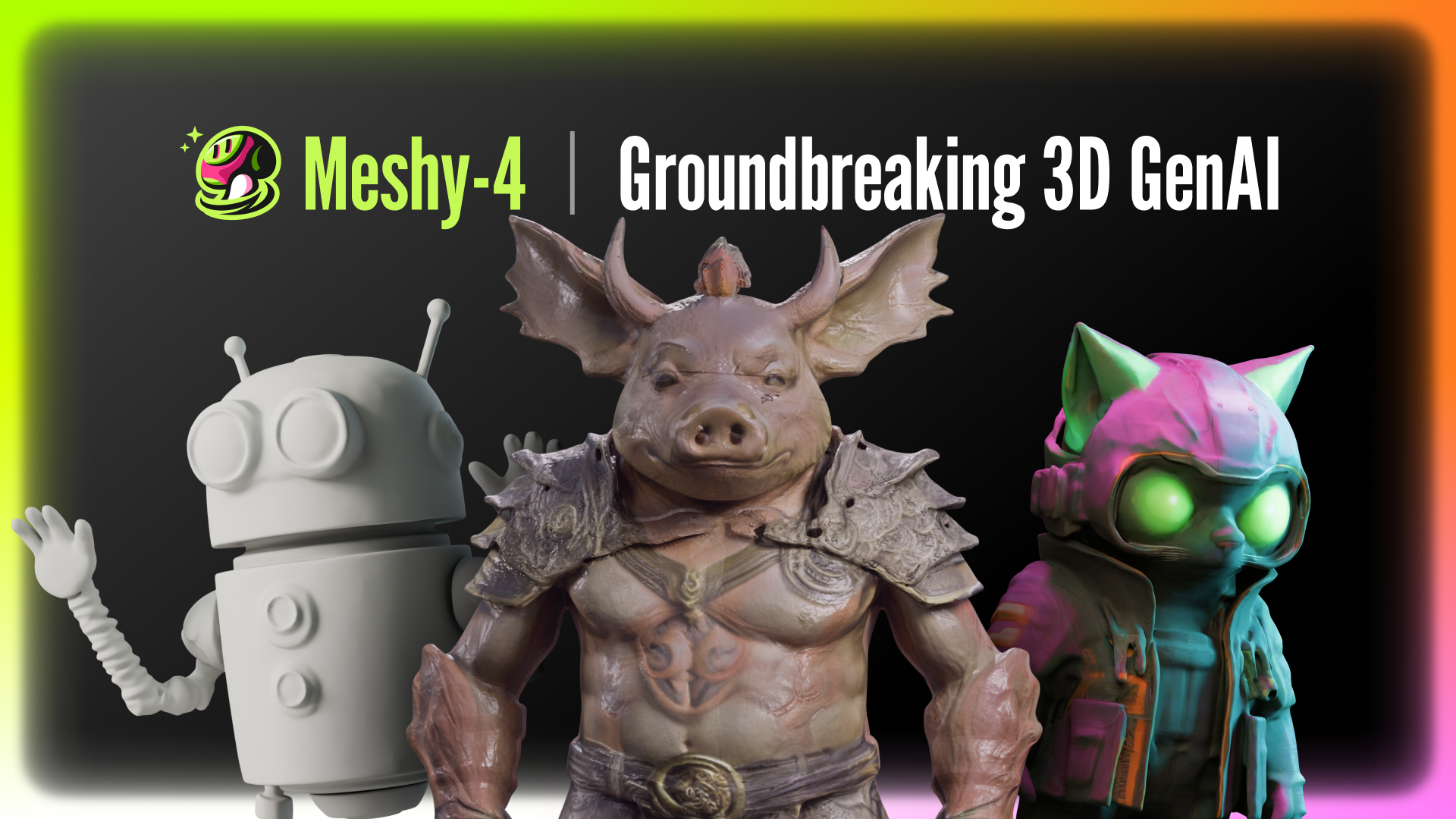

Przedstawiamy Meshy-1, szybki generatywny AI 3D, dający twórcom treści możliwość przekształcania tekstów i obrazów w fascynujące modele 3D w zaledwie minutę. Meshy-1 oferuje trzy łatwe w użyciu tryby:

- Tekst na 3D: Słowa wchodzą, modele 3D wychodzą

- Obraz na 3D: Zdjęcia dostarczone, modele 3D wyprodukowane

- Tekst na Teksturę: Teksturyzuj swoje modele za pomocą prostych opisów tekstowych [3]

Wszystkie trzy tryby działają szybko i dają wyniki w mniej niż 60 sekund.

W pełni wygenerowana przez AI scena. Każdy model w tej scenie jest wygenerowany przy użyciu Meshy-1 Tekst na 3D.Budując na wspólnej podstawie Meshy-1, trzy tryby dzielą wspólne cechy, które wcześniej nie były dostępne w istniejących produktach:

30x szybciej. Istniejące produkty mogą sprawić, że użytkownicy czekają godzinami, a my uważamy, że to nie do przyjęcia. Meshy-1 rewolucjonizuje ten proces, dostarczając wyniki w mniej niż minutę[4]. Nie tylko poprawia to doświadczenie użytkownika i produktywność, ale niezwykła wydajność Meshy-1 pozwala nam znacznie obniżyć koszt generacji po stronie użytkownika.

Przyjazny dla przepływu pracy. Upewnienie się, że modele 3D są gotowe do użycia w aplikacjach downstream jest kluczowe. Obsługujemy formaty wyjściowe takie jak glb, usdz i fbx. W przyszłym tygodniu wprowadzamy również wtyczkę Unity, a później pojawią się wtyczki do Blender & UE. Planujemy również dodać opcję kontroli liczby wielokątów, która pozwala na redukcję liczby wielokątów w aplikacji webowej.

![]()

Wysokiej jakości tekstury. Meshy-1 dostarcza przełom w jakości tekstur.

- Rozdzielczość 4K. Rozdzielczość ma znaczenie, a tekstury Meshy-1 są ostre jak brzytwa.

- Kanały PBR. Fizycznie oparte renderowanie (PBR) stało się kluczowe w grach i filmach, a Meshy-1 generuje mapy metaliczności, szorstkości i normalne dla fizycznego realizmu.

- Wsparcie dla wielu materiałów w trybie Tekst na Teksturę. Gdy generujesz tekstury dla istniejącego modelu 3D, często zdarza się, że twój model ma wiele zestawów UV i wiele grup map tekstur. Nasz tryb tekst na teksturę dobrze obsługuje takie przypadki.

Kontrola stylu. W trybach Tekst na 3D i Tekst na Teksturę Meshy-1, możesz wybierać spośród różnych stylów artystycznych dla swojej generacji, w tym Realistyczny, Kreskówkowy, Anime, Komiksowy i więcej. Daje to znaczną kontrolę nad stylem artystycznym, wykraczającą poza to, co mogą umożliwić same tekstowe podpowiedzi.

Jak z tego korzystać?

Meshy-1 jest łatwo dostępny zarówno w naszej aplikacji webowej, jak i na Discordzie. Oferując podobne funkcjonalności na obu platformach, istnieją pewne różnice do zauważenia:

- Discord oferuje nieograniczone darmowe generacje, choć twoje kreacje są publicznie widoczne na kanale generacyjnym.

- Aplikacja Webowa zapewnia 20 darmowych generacji dziennie i dodaje dodatkowe możliwości, takie jak kolejkowanie zadań, kanały PBR, kontrola stylu, udostępnianie linków oraz zarządzanie przestrzenią roboczą generacji.

Najnowsze funkcje Tekst na Teksturę i Obraz na 3D są łatwo dostępne zarówno na Discordzie, jak i w aplikacji webowej. Zaktualizowany Tekst na 3D można znaleźć na Discordzie już dziś, a będzie dostępny w aplikacji webowej za kilka tygodni. Jak więc wykorzystać te funkcje w rzeczywistym świecie? Dzięki wczesnym użytkownikom odkryliśmy wzorce skutecznego generowania 3D: używaj Text to 3D do rekwizytów (sztuka środowiskowa), a Image to 3D do postaci.

Text to 3D dla rekwizytów. Wystarczy wpisać tekstowy prompt i pozwolić Meshy-1 tworzyć modele zgodnie z Twoim opisem, idealne do generowania zasobów środowiskowych lub "rekwizytów" w grach. Zapewnij spójny styl, korzystając z naszej opcji stylu.

Scena stworzona przez RenderMan, starszego artystę UE z Nowego Jorku, wszystko wygenerowane za pomocą Meshy-1 Text to 3D.Image to 3D dla postaci. Wykorzystaj obraz z widokiem z przodu, w tym te z Midjourney lub Stable Diffusion, a Meshy-1 przekształci go w model 3D. Funkcja Image to 3D zapewnia silną kontrolę nad wynikiem, tworząc autentyczną reprezentację 3D Twojego 2D wejścia, co czyni ją ulubioną wśród wczesnych użytkowników do tworzenia postaci.

Scena autorstwa Samuela, artysty CG w Tokio, wczesnego użytkownika Meshy. Wszystkie postacie są wygenerowane za pomocą Meshy-1 Image to 3D, a następnie animowane za pomocą Mixamo.Jak wybrać odpowiednie obrazy? Preferuj widoki z przodu (z kamerą ustawioną bezpośrednio przed postacią) i czyste tło.

![]()

Reteksturowanie modeli za pomocą Text to Texture. Korzystając z naszego sprawdzonego trybu Text to Texture, możesz łatwo tworzyć lub zastępować tekstury istniejących modeli, zwłaszcza tych generowanych przez AI.

Beyond the Horizon

![]()

Naszym celem jest ustanowienie Meshy jako wiodącej platformy w 3D GenAI. Chociaż Meshy-1 stanowi znaczący krok naprzód, nie jest to ostatni rozdział. W rzeczywistości postęp technologiczny GenAI dla 3D pozostaje w tyle za GenAI dla tekstu lub obrazów. Dzieje się tak, ponieważ 3D wprowadza więcej wymiarów i złożoności. Dlatego produkty 3D GenAI potrzebują czasu, aby naprawdę osiągnąć jakość produkcyjną.

Oprócz optymalizacji wyników Meshy-1, eksplorujemy następujące kierunki dla naszej mapy drogowej produktu, kierując się opiniami użytkowników i nauką,

Poprawiona jakość siatki. Obecne ograniczenia generatywnej AI, takie jak wysokie liczby wielokątów (zwykle 100K+), słaba jakość rozwijania UV i brak twarzy czworokątnych, ograniczają jej zdolność do generowania zasobów gotowych do produkcji. Rozwiązanie tych ograniczeń jest kluczowe, zwłaszcza biorąc pod uwagę preferencje branży dla twarzy czworokątnych w animacji i modeli o niskiej liczbie wielokątów do gier mobilnych.

Iteracje konwersacyjne. W miarę jak użytkownicy odchodzą od tradycyjnego oprogramowania do modelowania 3D, takiego jak Maya i 3Ds Max, pragną większej kontroli nad wynikami generowanymi przez AI. Warto umożliwić użytkownikom możliwości iteracyjnego udoskonalania, przypominające wielorundowe interakcje w stylu ChatGPT.

Zwiększona kontrola. Na przykład użytkownicy chcą tworzyć modele 3D, generując je z wielu perspektyw 2D, takich jak widok z przodu, z boku i z tyłu. Dla obrazu do 3D wierzymy, że generowanie z wielu widoków jest ważnym kierunkiem.

Wyniki z zachowaniem spójności stylu. Spójność w renderowaniu stylistycznym jest powtarzającym się żądaniem użytkowników, podkreślając potrzebę, aby modele trzymały się określonego motywu wizualnego. Na koniec, serdeczne podziękowania i uznanie dla całego zespołu Meshy AI. Nasz obecny sukces jest świadectwem niezachwianego zaangażowania i wysiłków każdego z nas. Patrząc w przyszłość, horyzont jest obiecujący i nie mam wątpliwości, że razem będziemy nadal innowacyjni i doskonali. Pozostańcie zaangażowani, ponieważ jesteśmy na progu odsłonięcia czegoś jeszcze bardziej niezwykłego!

[1]Przed rozpoczęciem przygody z Meshy, ukończyłem doktorat z CG i AI na MIT, przyczyniając się do badań opublikowanych na renomowanych konferencjach, takich jak SIGGRAPH i ICLR. Po ukończeniu studiów doktoranckich w ciągu 3,5 roku, spędziłem kolejne 2,5 roku jako założyciel startupu, co pozwoliło mi połączyć moją wiedzę akademicką z praktycznymi aspektami budowania rzeczywistych produktów, cały czas ucząc się i rozwijając w tej dynamicznej dziedzinie.

[2]Dlaczego my? Zespół Meshy składa się z ekspertów z renomowanych instytucji i firm, takich jak MIT, Harvard, NVIDIA, Microsoft, Google i Meta, z głęboką wiedzą w dziedzinie grafiki komputerowej, AI, GPU, programowania różniczkowego i przetwarzania w chmurze. Wcześniej stworzyliśmy produkty zorientowane na deweloperów i użytkowników, które zostały dobrze przyjęte przez naszą bazę użytkowników. Te doświadczenia stanowią solidną podstawę do stworzenia produktu generatywnego AI 3D.

[3]W marcu 2023 roku wprowadziliśmy narzędzie o nazwie Meshy Texturer, ale teraz Meshy-1 jest tutaj z ulepszonym Text to Texture. Możesz sparować Meshy Texturer z naszymi trybami Text to 3D i Image to 3D, co pozwala na dostosowanie tekstur na wygenerowanych przez AI wynikach.

[4]Dane uzyskane w warunkach laboratoryjnych. W okresach dużego obciążenia serwera czas oczekiwania może przekroczyć jedną minutę.